권호기사보기

| 기사명 | 저자명 | 페이지 | 원문 | 기사목차 |

|---|

| 대표형(전거형, Authority) | 생물정보 | 이형(異形, Variant) | 소속 | 직위 | 직업 | 활동분야 | 주기 | 서지 | |

|---|---|---|---|---|---|---|---|---|---|

| 연구/단체명을 입력해주세요. | |||||||||

|

|

|

|

|

|

* 주제를 선택하시면 검색 상세로 이동합니다.

Title Page

Contents

Abstract 10

초록 11

Chapter 1. Introduction 12

1.1. Overview 12

1.2. Contribution 14

Chapter 2. Background 15

2.1. Task-Oriented Dialogue 15

2.2. ChatGPT Capabilities 17

Chapter 3. Methodology 20

3.1. Methodology 20

3.1.1. Adapter for each task (NLU, DST, NLG) 20

3.1.2. Metric-Aware Reinforcement Learning for DST & NLG module 22

3.1.3. ChatGPT Refinement Process for DST 24

Chapter 4. Experiments 27

4.1. Experimental Setup 27

4.1.1. Datasets 27

4.1.2. Baselines & Settings 27

4.2. Experimental Results 29

4.2.1. Dialogue State Tracking 29

4.2.2. End-to-End Response Generation 31

4.2.3. Further Analysis of Reinforcement Learning 32

4.2.4. ChatGPT Refinement Process Qualitative Analysis 35

Chapter 5. Conclusion 38

5.1. Summary 38

5.2. Limitations 39

Appendices 40

A. Units of Adapters 40

B. w/o Reinforcement Learning of TOATODsmall[이미지참조] 41

C. Implementation Details 41

Bibliography 42

FIGURE 1.1. Overview of the Task-Optimized Adapters for an End-to-End Task-Oriented Dialogue System 12

FIGURE 3.1. Architecture of the sub-modules in TOATOD. 21

FIGURE 3.2. Overview of Dialogue State Refinement Process 24

FIGURE 3.3. Prompt examples of the restaurant domain. 25

FIGURE 4.1. Effect of hyperparameter a 34

FIGURE 4.2. Example of the cases of wrong refinement. 35

*표시는 필수 입력사항입니다.

| 전화번호 |

|---|

| 기사명 | 저자명 | 페이지 | 원문 | 기사목차 |

|---|

| 번호 | 발행일자 | 권호명 | 제본정보 | 자료실 | 원문 | 신청 페이지 |

|---|

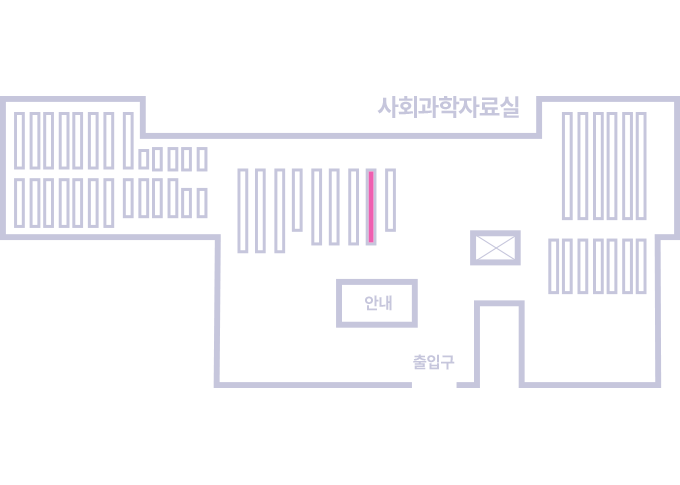

도서위치안내: / 서가번호:

우편복사 목록담기를 완료하였습니다.

*표시는 필수 입력사항입니다.

저장 되었습니다.